ライトフィールド

光場(ライトフィールド)は、空間内のあらゆる点をあらゆる方向に通過する光の量を記述するベクトル関数です。あらゆる光線の空間は5次元プレノプティック関数によって与えられ、各光線の強度はその放射輝度によって与えられます。マイケル・ファラデーは、光を磁場のように場として解釈すべきだと初めて提唱しました。[ 1 ]ライトフィールドという用語は、1936年にアンドレイ・ガーシュンが3次元空間における光の放射特性に関する古典的な論文で 提唱しました。

「放射場」という用語は、類似の概念、あるいは同一の概念を指すために使用されることもあります[ 2 ] 。この用語は、神経放射場などの現代の研究で使用されています。

プレノプティック機能

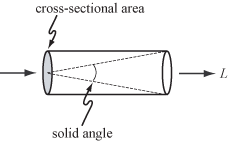

幾何光学、すなわち非干渉性光や光の波長よりも大きな物体においては、光の基本的な媒介は光線です。光線に沿って伝わる光の量は放射輝度で、 Lで表され、W·sr −1 ·m −2の単位で測定されます。つまり、ワット(W)/ステラジアン(sr)/平方メートル(m 2 )です。ステラジアンは立体角の単位であり、平方メートルは右に示すように断面積の単位として用いられます。

光の不変配置によって照らされた 3 次元空間の領域におけるそのようなすべての光線に沿った放射輝度は、プレノプティック関数と呼ばれます。[ 3 ]プレノプティック照明関数は、コンピュータ ビジョンやコンピュータ グラフィックスで使用される理想的な関数であり、任意の時点における任意の視点からのシーンの画像を表します。これは実際には計算には使用されませんが、ビジョンやグラフィックスの他の概念を理解する上で概念的に役立ちます。[ 4 ]左に示すように、空間内の光線は 3 つの座標x、y、zと 2 つの角度θとϕでパラメーター化できるため、これは 5 次元関数、つまり3Dユークリッド空間と2 次元球面の積に相当する5 次元多様体上の関数です。

空間内の各点におけるライトフィールドは、その点に当たる方向ごとに 1 つずつ、長さが放射輝度に比例するベクトルの無限の集合として扱うことができます。

これらのベクトルを任意の光の集合、あるいは球面全体にわたって積分すると、単一のスカラー値、すなわちその点における総放射照度と、結果として得られる方向が得られます。図は、2つの光源の場合のこの計算を示しています。コンピュータグラフィックスでは、この3次元空間のベクトル値関数はベクトル放射照度場と呼ばれます。[ 6 ]場内の各点におけるベクトル方向は、その点に置かれた平面が最も明るく照らされる方向として解釈できます。

高次元性

時間、波長、偏光角は追加の次元として扱うことができ、それに応じてより高次元の関数が生成されます。

4Dライトフィールド

プレノプティック関数において、対象領域に凹面物体(例えば、カップ状の手)が含まれている場合、物体上の一点から発せられた光は、物体上の別の点に遮られるまで、ごく短い距離しか進まない可能性があります。このような領域でこの関数を測定する実用的な装置は存在しません。

しかし、物体の凸包の外側にある場所(例えばシュリンクラップ)では、プレノプティック関数は複数の画像を撮影することで測定できます。この場合、光線に沿った放射輝度はその長さ全体にわたって一定であるため、関数には冗長情報が含まれます。冗長情報は正確に1次元であり、結果として4次元関数が形成されます。この関数は光場、4D光場[ 7 ] 、ルミグラフ[ 8 ]など様々な名称で呼ばれます。正式には、この場は空の空間における光線に沿った放射輝度として定義されます。

ライトフィールド内の光線集合は、様々な方法でパラメータ化できます。最も一般的な方法は、2平面パラメータ化です。このパラメータ化では、例えば2つの平面が互いに平行である場合に、それらの平面に平行な光線を表現するなど、すべての光線を表現できるわけではありませんが、透視投影画像の解析幾何学と密接に関連しています。2平面ライトフィールドを簡単に考えると、UV平面上の観測者の位置からそれぞれ撮影された、 ST平面(およびST平面をまたぐ、またはST平面の向こう側にある可能性のあるオブジェクト)の透視画像の集合体と捉えることができます。このようにパラメータ化されたライトフィールドは、ライトスラブと呼ばれることもあります。

サウンドアナログ

音における4Dライトフィールドの類似物は、音場、あるいは波動場(波動場合成)であり、対応するパラメータ化はキルヒホッフ・ヘルムホルツ積分です。これは、障害物がない場合、時間経過に伴う音場は平面上の圧力によって与えられることを示しています。したがって、これは任意の時点では2次元の情報であり、時間の経過とともに3次元の場となります。

光の見かけ上の四次元性と比較すると、この二次元性は、光が光線(ある時点では0次元、時間の経過とともに1次元)として進行するのに対し、ホイヘンス・フレネルの原理によれば、音波面は球面波(ある時点では2次元、時間の経過とともに3次元)としてモデル化できるためです。つまり、光は一方向(情報の2次元)に進みますが、音はあらゆる方向に広がります。しかし、真空でない媒質を伝わる光も同様に散乱する可能性があり、散乱によって失われる不可逆性、つまり情報は、見かけ上のシステム次元の損失として識別できます。

画像の再フォーカス

ライトフィールドは空間情報と角度情報を提供するため、露光後に焦点面の位置を変更することができます。これはしばしばリフォーカスと呼ばれます。リフォーカスの原理は、積分変換を用いてライトフィールドから従来の2次元写真を得ることです。この変換はライトフィールドを入力として受け取り、特定の平面に焦点を合わせた写真を生成します。

が第1の平面上の位置から第2の平面上の位置まで移動する光線を記録する4次元光場を表し、ここでが2つの平面間の距離であると仮定すると、任意の深さでの2次元写真は、次の積分変換から得ることができる:[ 9 ]

- 、

あるいはもっと簡潔に言えば、

- 、

ここで、、、は写真演算子です。

実際には、プレノプティックカメラは通常、光照射野の離散的なサンプルを撮影するため、この式を直接使用することはできない。そのため、を計算するには再サンプリング(または補間)が必要となる。もう一つの問題は、計算量が非常に多いことである。4次元光照射野から2次元写真を計算する場合、この式の計算量は となる。[ 9 ]

フーリエスライス写真

計算の複雑さを軽減する一つの方法は、フーリエスライス定理の概念を採用することです。[ 9 ]写真演算子は、せん断とそれに続く投影と見なすことができます。結果は、ライトフィールドの4次元フーリエ変換の拡大された2次元スライスに比例するはずです。より正確には、ライトフィールドの4次元フーリエスペクトルから2次元スライスを抽出し、逆2次元変換を適用し、スケーリングすることで、再焦点画像を生成することができます。このアルゴリズムの漸近複雑度は です。

離散焦点スタック変換

2次元写真を効率的に計算するもう一つの方法は、離散焦点スタック変換(DFST)を用いることです。[ 10 ] DFSTは、再焦点化された2次元写真、いわゆるフォーカルスタックを生成するように設計されています。この手法は、高速分数フーリエ変換(FrFT) によって実装できます。

離散写真演算子は、 4次元グリッドでサンプリングされたライトフィールドに対して次のように定義されます。

通常、4D グリッド上には存在しないため、DFST は三角関数の補間を採用して非グリッド値を計算します。

アルゴリズムは次のステップで構成されます。

- サンプリング周期とでライトフィールドをサンプリングし、離散化されたライトフィールドを取得します。

- エイリアシングなしで FrFT に十分な信号長になるようにゼロを埋め込みます。

- あらゆる について、の離散フーリエ変換を計算し、結果 を取得します。

- すべての焦点距離 に対して、の分数フーリエ変換を計算します。ここで、変換の順序は に依存し、結果 を取得します。

- の逆離散フーリエ変換を計算します。

- の周辺ピクセルを削除して、各2D写真のサイズを

ライトフィールドを作成する方法

コンピュータグラフィックスにおいて、ライトフィールドは通常、3Dモデルのレンダリングまたは実際のシーンの撮影によって生成されます。どちらの場合も、ライトフィールドを生成するには、多数の視点からのビューを取得する必要があります。パラメータ化に応じて、このビューの集合は通常、線、円、平面、球、またはその他の形状の一部にまたがりますが、非構造化の集合も可能です。[ 11 ]

ライトフィールドを写真的に捉える装置としては、移動する手持ちカメラやロボット制御のカメラ、[ 12 ]アーク状のカメラ(マトリックスで使用されたバレットタイム効果のように)、密集したカメラアレイ、[ 13 ]手持ちカメラ、[ 14 ] [ 15 ]顕微鏡、[ 16 ]またはその他の光学システムなどがあります。[ 17 ]

ライトフィールド内の画像数はアプリケーションによって異なります。ミケランジェロの「夜の女神像」 [ 18 ]のライトフィールドキャプチャには、1.3メガピクセルの画像が24,000枚含まれており、2022年時点では大規模と見なされています。ライトフィールドレンダリングで不透明な物体を完全にキャプチャするには、少なくとも前面と背面の画像を撮影する必要があります。また、st平面にまたがる物体の場合は、 (上記の2平面パラメータ化において) uv平面上で細かく間隔をあけて画像を撮影する必要があります。

ライトフィールド内の画像の数と配置、および各画像の解像度は、まとめて4Dライトフィールドの「サンプリング」と呼ばれます。[ 19 ]また、オクルージョン、 [ 20 ]照明と反射の効果も重要です。 [ 21 ]

アプリケーション

照明工学

ガーシュンが光場を研究した理由は、様々な形状の光源を表面上に配置した場合に、表面上で観察される照明パターンを(閉じた形で)導くことであった。[ 23 ]照明工学を専門とする光学の分野は非結像光学である。[ 24 ]この分野では、流線(ガーシュンの光束線)とベクトル流束(ガーシュンの光ベクトル)の概念が広く用いられている。しかし、光場(この場合、光線を定義する位置と方向)は、一般的に位相空間とハミルトン光学によって記述される。

ライトフィールドレンダリング

シーンの4Dライトフィールドから適切な2Dスライスを抽出することで、シーンの新しいビューが可能になります。[ 25 ]ライトフィールドとスライスのパラメータ化に応じて、これらのビューは透視投影、正投影、交差スリット、[ 26 ]一般的なリニアカメラ、[ 27 ]マルチパースペクティブ、[ 28 ]またはその他の投影法になる可能性があります。ライトフィールドレンダリングは、画像ベースレンダリングの一種です。

合成絞り写真

ライトフィールド内のサンプルの適切な4Dサブセットを統合することで、有限の(つまりピンホールではない)絞りを持つカメラで撮影される視野を近似することができます。このような視野は有限の被写界深度を持ちます。この統合を行う前にライトフィールドをシアーまたはワープすることで、異なる前頭平行面[ 29 ]または斜面[ 30 ]に焦点を合わせることができます。ライトフィールドを捉えるデジタルカメラ[ 14 ]で撮影された画像は、再フォーカスが可能です。

3Dディスプレイ

各サンプルを物理空間内の適切な光線にマッピングする技術を用いてライトフィールドを提示すると、元のシーンを見ているのと同じような裸眼立体視効果が得られます。これを実現するための非デジタル技術には、インテグラルフォトグラフィー、視差パノラマグラム、ホログラフィーなどがあります。デジタル技術には、高解像度のディスプレイ画面上にレンズレットアレイを配置したり、ビデオプロジェクターアレイを用いてレンズレットアレイに画像を投影したりすることが含まれます。ビデオカメラアレイは、時間とともに変化するライトフィールドを捉えて表示することができます。これは基本的に3Dテレビシステムを構成します。[ 31 ]ライトフィールドディスプレイの現代的なアプローチでは、光学素子と圧縮計算の協調設計を探求することで、より高い解像度、高いコントラスト、広い視野などの利点を実現しています。[ 32 ]

脳画像

神経活動は、 GCaMPなどの可逆的な蛍光マーカーをニューロンに遺伝子コード化することで光学的に記録できます。GCaMPはカルシウムイオンの存在をリアルタイムで示します。光視野顕微鏡は、1フレームで全体積情報を捉えることができるため、大規模な体積内にランダムに分布する個々のニューロンの神経活動をビデオフレームレートでモニタリングすることが可能です。[ 33 ]脳組織の光学的異常や体積画像の再構成なしに、神経活動の定量的な測定が可能であり、 [ 34 ]数千個のニューロンの活動をモニタリングするために使用できます。[ 35 ]

一般化シーン再構成(GSR)

これは、一般化された光場と再照明可能な物質場を表現するシーンモデルを作成および/または改良する方法である。[ 36 ]再構成に使用されるデータには、画像、ビデオ、オブジェクトモデル、および/またはシーンモデルが含まれる。一般化された光場は、シーン内を流れる光を表現する。再照明可能な物質場は、シーンを占める物質の光相互作用特性と放射率を表現する。シーンデータ構造は、ニューラルネットワーク[ 37 ] [ 38 ] [ 39 ] や物理ベースの構造[ 40 ] [ 41 ]などを使用して実装することができる。[ 36 ]光場と物質場は、少なくとも部分的に分離されている。[ 36 ] [ 42 ]

ホログラフィックステレオグラム

ホログラフィックステレオグラムのための合成画像の生成とプリディストーションは、計算されたライトフィールドの最も初期の例の1つです。[ 43 ]

グレア低減

グレアは、カメラ本体とレンズ光学系内での光の多重散乱によって発生し、画像のコントラストを低下させます。グレアは2次元画像空間で解析されてきましたが[ 44 ] 、 4次元光線空間現象として識別することが有用です[ 45 ] 。カメラ内部の光線空間を統計的に解析することで、グレアアーティファクトの分類と除去が可能になります。光線空間では、グレアは高周波ノイズとして振る舞い、外れ値除去によって低減できます。このような解析はカメラ内部のライトフィールドをキャプチャすることで実行できますが、空間解像度の低下を招きます。均一および不均一な光線サンプリングを使用することで、画像解像度を大幅に損なうことなくグレアを低減できます[ 45 ] 。

参照

注記

- ^ファラデー、マイケル(2009年4月30日)「LIV. 光線振動に関する考察」『哲学雑誌』シリーズ3. 28 (188): 345– 350. doi : 10.1080/14786444608645431 . 2013年2月18日時点のオリジナルよりアーカイブ。

- ^ Mildenhall, Ben; Srinivasan, Pratul P; Tancik, Matthew; Barron, Jonathan T; Ramamoorthi, Ravi; Ng, Ren (2021-12-17). 「NeRF:ビュー合成のためのニューラル放射場としてのシーン表現」 Communications of the ACM . 65 (1): 99– 106. doi : 10.1145/3503250 .

- ^アデルソン 1991

- ^ウォン 2002

- ^ゲルシュン、図17

- ^アルヴォ、1994

- ^レボイ 1996

- ^ゴートラー 1996

- ^ a b cン、レン (2005). 「フーリエスライス写真」。ACM SIGGRAPH 2005 論文。米国ニューヨーク州ニューヨーク:ACM Press。 pp. 735–744。土井:10.1145/1186822.1073256。ISBN 978-1-4503-7825-3. S2CID 1806641 .

- ^ナバ、F. ペレス;マリシャル・エルナンデス、JG。ロドリゲス=ラモス、JM(2008年8月)。「離散フォーカルスタック変換」。2008 第 16 回欧州信号処理会議: 1–5 .

- ^ビューラー 2001

- ^レボイ 2002

- ^奏 1998;ヤン 2002;ウィルバーン 2005

- ^ a b Ng 2005

- ^ゲオルギエフ 2006; マルワ 2013

- ^レボイ 2006

- ^ボレス 1987

- ^ 「ミケランジェロの『夜の像』の光のフィールド」 accademia.stanford.edu . 2022年2月8日閲覧。

- ^チャイ(2000)

- ^デュランド(2005)

- ^ラマムーティ(2006)

- ^ゲルシュン、図24

- ^アッシュダウン 1993

- ^チャベス 2015; ウィンストン 2005

- ^レボイ 1996; ゴートラー 1996

- ^ゾメット 2003

- ^ユウとマクミラン 2004

- ^ラデマッハー 1998

- ^イサクセン 2000

- ^ヴァイシュ 2005

- ^ジャビディ 2002; マトゥシク 2004

- ^ウェッツスタイン 2012, 2011; ランマン 2011, 2010

- ^グローセニック、2009、2017;ペレス、2015

- ^ペガード、2016年

- ^グロゼニック、2017年

- ^ a b cレフィングウェル、2018

- ^ミルデンホール、2020年

- ^ Rudnev, Viktor; Elgharib, Mohamed; Smith, William; Liu, Lingjie; Golyanik, Vladislav; Theobalt, Christian (2022年7月21日). 「屋外シーンの再照明のためのNeRF」. European Conference on Computer Vision (ECCV) 2022 : 1– 22. arXiv : 2112.05140 .

- ^ Srinivasan, Pratual; Deng, Boyang; Zhang, Xiuming; Tancik, Matthew; Mildenhall, Ben; Barron, Jonathan (2020年12月7日). 「NeRV: 再照明と視界合成のための神経反射率と可視フィールド」. CVPR : 1–12 . arXiv : 2012.03927 .

- ^ Yu & Fridovich-Keil、2021年

- ^ Kerbl, Bernhard; Kopanas, Georgios; Leimkühler, Thomas; Drettakis, George (2023-08-08). 「リアルタイム放射輝度場レンダリングのための3Dガウススプラッティング」. arXiv : 2308.04079 [ cs.GR ].

- ^ Zhang, Jingyang; Yao, Yao; Li, Shiwei; Liu, Jingbo; Fang, Tian; McKinnon, David; Tsin, Yanghai; Quan, Long (2023年3月30日). 「NeILF++: 形状と材質推定のための相互反射型ライトフィールド」. pp. 1– 5. arXiv : 2303.17147 [ cs.CV ].

- ^ハレ 1991、1994

- ^タルヴァラ 2007

- ^ a bラスカー 2008

参考文献

理論

- Adelson, EH, Bergen, JR (1991). 「プレノプティック関数と初期視覚の要素」 , M. LandyとJA Movshon編, MIT Press , Cambridge, 1991, pp. 3–20.

- Arvo, J. (1994). 「部分的に遮蔽された多面体光源の放射照度ヤコビアン」 , Proc. ACM SIGGRAPH , ACM Press, pp. 335–342.

- Bolles, RC, Baker, HH, Marimont, DH (1987). 「エピポーラ平面画像解析:動きから構造を判定するアプローチ」 , International Journal of Computer Vision , Vol. 1, No. 1, 1987, Kluwer Academic Publishers, pp 7–55.

- ファラデー、M.、「光線振動に関する考察」Wayback Machineに 2013 年 2 月 18 日にアーカイブ、哲学雑誌、S.3、第 XXVIII 巻、N188、1846 年 5 月。

- ゲルシュン, A. (1936). 「光場」, モスクワ, 1936. P. ムーンと G. ティモシェンコ訳, Journal of Mathematics and Physics , 第18巻, MIT, 1939年, pp. 51–151.

- Gortler, SJ, Grzeszczuk, R., Szeliski, R., Cohen, M. (1996). 「The Lumigraph」 , Proc. ACM SIGGRAPH , ACM Press, pp. 43–54.

- Levoy, M., Hanrahan, P. (1996). 「ライトフィールドレンダリング」 , Proc. ACM SIGGRAPH , ACM Press, pp. 31–42.

- ムーン, P., スペンサー, DE (1981). 『The Photic Field』 , MIT Press.

- Wong, TT, Fu, CW, Heng, PA, Leung CS (2002). 「プレノプティック照明関数」 , IEEE Trans. Multimedia , Vol. 4, No. 3, pp. 361–371.

分析

- G. Wetzstein、I. Ihrke、W. Heidrich (2013) 「プレノプティック多重化と再構成について」、International Journal of Computer Vision (IJCV)、第 101 巻、第 2 号、pp. 384–400。

- Ramamoorthi, R., Mahajan, D., Belhumeur, P. (2006). 「照明、陰影、影の一次分析」 ACM TOG .

- Zwicker, M., Matusik, W., Durand, F., Pfister, H. (2006). 「Automultiscopic 3D Displays のアンチエイリアシング」Wayback Machineに2016年10月18日アーカイブ、Eurographics Symposium on Rendering、2006年。

- Ng, R. (2005). 「フーリエスライス写真」 , Proc. ACM SIGGRAPH , ACM Press, pp. 735–744.

- Durand, F., Holzschuch, N., Soler, C., Chan, E., Sillion, FX (2005). 「光輸送の周波数解析」 , Proc. ACM SIGGRAPH , ACM Press, pp. 1115–1126.

- Chai, J.-X., Tong, X., Chan, S.-C., Shum, H. (2000). 「プレノプティックサンプリング」 , Proc. ACM SIGGRAPH , ACM Press, pp. 307–318.

- Halle, M. (1994) 「離散画像システムとしてのホログラフィックステレオグラム」、SPIE Proc. Vol. #2176: Practical Holography VIII、SA Benton 編、pp. 73–84。

- Yu, J., McMillan, L. (2004). 「一般線形カメラ」 , Proc. ECCV 2004 ,コンピュータサイエンス講義ノート, pp. 14–27.

カメラ

- Marwah, K., Wetzstein, G., Bando, Y., Raskar, R. (2013). 「過剰完備辞書と最適化された投影を用いた圧縮ライトフィールド写真」Wayback Machineに2021年11月28日アーカイブ、ACM Transactions on Graphics (SIGGRAPH)。

- Liang, CK, Lin, TH, Wong, BY, Liu, C., Chen, HH (2008). 「プログラマブル・アパーチャー・フォトグラフィー:多重化ライトフィールド取得」 , Proc. ACM SIGGRAPH .

- Veeraraghavan, A., Raskar, R., Agrawal, A., Mohan, A., Tumblin, J. (2007). 「ダップル写真:ヘテロダイン光照射野と符号化開口再フォーカスのためのマスク強化カメラ」 , Proc. ACM SIGGRAPH .

- Georgiev, T., Zheng, C., Nayar, S., Curless, B., Salesin, D., Intwala, C. (2006). 「インテグラルフォトグラフィーにおける空間解像度と角度解像度のトレードオフ」 , Proc. EGSR 2006 .

- 金出 剛志、斉藤 秀、ヴェデュラ 聡 (1998). 「3Dルーム:同期した複数のビデオストリームによる時間変動3Dイベントのデジタル化」技術レポートCMU-RI-TR-98-34、1998年12月。

- Levoy、M. (2002)。スタンフォード球状ガントリー。

- Levoy, M., Ng, R., Adams, A., Footer, M., Horowitz, M. (2006). 「ライトフィールド顕微鏡法」 , ACM Transactions on Graphics (Proc. SIGGRAPH), Vol. 25, No. 3.

- Ng, R., Levoy, M., Brédif, M., Duval, G., Horowitz, M., Hanrahan, P. (2005). 「手持ちプレノプティックカメラによるライトフィールド写真術」スタンフォード技術レポートCTSR 2005–02、2005年4月。

- Wilburn, B., Joshi, N., Vaish, V., Talvala, E., Antunez, E., Barth, A., Adams, A., Levoy, M., Horowitz, M. (2005). 「大規模カメラアレイを用いた高性能イメージング」 , ACM Transactions on Graphics (Proc. SIGGRAPH), Vol. 24, No. 3, pp. 765–776.

- Yang, JC, Everett, M., Buehler, C., McMillan, L. (2002). 「リアルタイム分散ライトフィールドカメラ」 , Proc. Eurographics Rendering Workshop 2002 .

- 「CAFADISカメラ」

ディスプレイ

- Wetzstein, G., Lanman, D., Hirsch, M., Raskar, R. (2012). 「Tensorディスプレイ:指向性バックライト付き多層ディスプレイを用いた圧縮ライトフィールドディスプレイ」 ACM Transactions on Graphics (SIGGRAPH)

- Wetzstein, G., Lanman, D., Heidrich, W., Raskar, R. (2011). 「Layered 3D: 減衰ベースライトフィールドおよびハイダイナミックレンジディスプレイのためのトモグラフィー画像合成」 , ACM Transactions on Graphics (SIGGRAPH)

- Lanman, D., Wetzstein, G., Hirsch, M., Heidrich, W., Raskar, R. (2011). 「偏光場:多層LCDを用いた動的ライトフィールドディスプレイ」Wayback Machineに2015年2月19日にアーカイブ、ACM Transactions on Graphics (SIGGRAPH Asia)

- Lanman, D., Hirsch, M. Kim, Y., Raskar, R. (2010). 「HR3D: デュアルスタックLCDを用いたグラスフリー3Dディスプレイ コンテンツ適応型視差バリアを用いた高ランク3Dディスプレイ」 2013年6月21日アーカイブ、Wayback Machine、ACM Transactions on Graphics (SIGGRAPH Asia)

- Matusik, W., Pfister, H. (2004). 「3D TV:動的シーンのリアルタイム取得、伝送、自動立体視表示のためのスケーラブルなシステム」 Proc . ACM SIGGRAPH、ACM Press。

- Javidi, B., Okano, F. 編 (2002). 『3次元テレビ、ビデオ、ディスプレイ技術』 Springer-Verlag.

- Klug, M., Burnett, T., Fancello, A., Heath, A., Gardner, K., O'Connell, S., Newswanger, C. (2013). 「スケーラブルで協調的なインタラクティブなライトフィールドディスプレイシステム」 , SIDシンポジウム技術論文ダイジェスト

- Fattal, D., Peng, Z., Tran, T., Vo, S., Fiorentino, M., Brug, J., Beausoleil, R. (2013). 「広角・裸眼3Dディスプレイのための多方向バックライト」 Nature 495, 348–351

アーカイブ

- 「スタンフォード・ライトフィールド・アーカイブ」

- 「UCSD/MERL ライトフィールドリポジトリ」

- 「HCI ライトフィールド ベンチマーク」

- 「合成ライトフィールドアーカイブ」は2012年11月26日にWayback Machineにアーカイブされました

アプリケーション

- Grosenick, L., Anderson, T., Smith SJ (2009) 「神経細胞集団の生体内イメージングのための弾性源選択」ナノからマクロへ、第6回IEEE国際生物医学イメージングシンポジウム。(2009) 1263–1266。

- Grosenick, L., Broxton, M., Kim, CK, Liston, C., Poole, B., Yang, S., Andalman, A., Scharff, E., Cohen, N., Yizhar, O., Ramakrishnan, C., Ganguli, S., Suppes, P., Levoy, M., Deisseroth, K. (2017) 「哺乳類の脳における大規模な組織体積にわたる細胞活動ダイナミクスの特定」 bioRxiv 132688; doi:哺乳類の脳における大規模な組織体積にわたる細胞活動ダイナミクスの特定。

- Heide, F., Wetzstein, G., Raskar, R., Heidrich, W. (2013) 「圧縮ディスプレイ向け適応型画像合成」、ACM Transactions on Graphics (SIGGRAPH)

- Wetzstein, G., Raskar, R., Heidrich, W. (2011) 「ライトフィールドプローブを用いた手持ちシュリーレン写真」 IEEE 国際計算写真会議 (ICCP)

- Pérez, F., Marichal, JG, Rodriguez, JM (2008). 「離散フォーカルスタック変換」 , Proc. EUSIPCO

- Raskar, R., Agrawal, A., Wilson, C., Veeraraghavan, A. (2008). 「グレアを考慮した写真撮影:カメラレンズのグレア効果を低減するための4Dレイサンプリング」 , Proc. ACM SIGGRAPH.

- Talvala, EV., Adams, A., Horowitz, M., Levoy, M. (2007). 「ハイダイナミックレンジイメージングにおけるベールグレア」 , Proc. ACM SIGGRAPH.

- Halle, M., Benton, S., Klug, M., Underkoffler, J. (1991). 「The UltraGram: A Generalized Holographic Stereogram」 , SPIE Vol. 1461, Practical Holography V , SA Benton編, pp. 142–155.

- Zomet, A., Feldman, D., Peleg, S., Weinshall, D. (2003). 「モザイクによる新しい視点:交差スリット投影」IEEE Transactions on Pattern Analysis and Machine Intelligence (PAMI)、第25巻、第6号、2003年6月、741~754頁。

- Vaish, V., Garg, G., Talvala, E., Antunez, E., Wilburn, B., Horowitz, M., Levoy, M. (2005). 「Synthetic Aperture Focusing using a Shear-Warp Factorization of the Viewing Transform」 , Proc. Workshop on Advanced 3D Imaging for Safety and Security , in conjunction with CVPR 2005.

- Bedard, N., Shope, T., Hoberman, A., Haralam, MA, Shaikh, N., Kovačević, J., Balram, N., Tošić, I. (2016). 「中耳の3D生体内イメージングのためのライトフィールド耳鏡の設計」 Biomedical optics express , 8 (1), pp. 260–272.

- Karygianni, S., Martinello, M., Spinoulas, L., Frossard, P., Tosic, I. (2018). 「ライトフィールドデータからの自動鼓膜位置合わせ」IEEE 国際画像処理会議 (ICIP)

- Rademacher, P., Bishop, G. (1998). 「Multiple-Center-of-Projection Images」 , Proc. ACM SIGGRAPH , ACM Press.

- Isaksen, A., McMillan, L., Gortler, SJ (2000). 「動的に再パラメータ化されたライトフィールド」 , Proc. ACM SIGGRAPH , ACM Press, pp. 297–306.

- Buehler, C., Bosse, M., McMillan, L., Gortler, S., Cohen, M. (2001). 「非構造化ルミグラフレンダリング」 , Proc. ACM SIGGRAPH , ACM Press.

- アッシュダウン、I. (1993). 「近接場測光法:新しいアプローチ」 ,照明工学学会誌, 第22巻第1号, 1993年冬, pp. 163–180.

- Chaves, J. (2015) 「非結像光学入門 第2版」 CRC Press

- Winston, R.、Miñano, JC、Benitez, PG、Shatz, N.、Bortz, JC、(2005) 「Nonimageing Optics」、Academic Press

- Pégard, NC, Liu HY, Antipa, N., Gerlock M., Adesnik, H., Waller, L.. 3D神経活動記録のための圧縮光場顕微鏡法. Optica 3, no. 5, pp. 517–524 (2016).

- Leffingwell, J., Meagher, D., Mahmud, K., Ackerson, S. (2018). 「一般化されたシーン再構成」 arXiv:1803.08496v3 [cs.CV], pp. 1–13.

- Mildenhall, B., Srinivasan, PP, Tancik, M., Barron, JT, Ramamoorthi, R., & Ng, R. (2020). 「NeRF: ビュー合成のためのニューラル放射輝度場としてのシーン表現」 Computer Vision – ECCV 2020, 405–421.

- Yu, A., Fridovich-Keil, S., Tancik, M., Chen, Q., Recht, B., Kanazawa, A. (2021). 「プレノクセル:ニューラルネットワークを用いない放射場」 arXiv:2111.11215, pp. 1–25

- Perez, CC; Lauri, A; et al. (2015年9月). 「ターンキーライトフィールドカメラを用いたゼブラフィッシュ幼生の行動におけるカルシウム神経イメージング」 . Journal of Biomedical Optics . 20 (9) 096009. Bibcode : 2015JBO....20i6009C . doi : 10.1117/1.JBO.20.9.096009 . PMID 26358822 .

- Perez, CC, Lauri, A., Symvoulidis, P., Cappetta, M., Erdmann, A., & Westmeyer, GG (2015). ターンキーライトフィールドカメラを用いた行動中のゼブラフィッシュ幼生におけるカルシウム神経イメージング. Journal of Biomedical Optics, 20(9), 096009-096009.

- León, K., Galvis, L., Arguello, H. (2016). 「2D投影からの色分けされたアパーチャを用いた圧縮センシングに基づくマルチスペクトル光場(5Dプレノプティック関数)の再構成」Wayback Machineに2017年3月22日アーカイブ アンティオキア大学工科大学誌80, pp. 131.

={1 \over \alpha ^{2}F^{2}}\iint L_{F}\left(u\left(1-{\frac {1}{\alpha }}\right)+{\frac {s}{\alpha }},v\left(1-{\frac {1}{\alpha }}\right)+{\frac {t}{\alpha }},u,v\right)~dudv}](https://wikimedia.org/api/rest_v1/media/math/render/svg/60adeb0f381818bb17973638d56bce280c6c4ffe)

={\frac {1}{\alpha ^{2}F^{2}}}\int L_{F}\left({\boldsymbol {u}}\left(1-{\frac {1}{\alpha }}\right)+{\frac {\boldsymbol {s}}{\alpha }},{\boldsymbol {u}}\right)d{\boldsymbol {u}}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/93ee275f5a3c4e0535d9a48a10034709fcb261ad)

![{\displaystyle {\mathcal {P}}_{\alpha }\left[\cdot \right]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/b933f823d86642460379aaf0e72671e44822df25)

=\sum _{{\tilde {\boldsymbol {u}}}=-{\boldsymbol {n}}_{\boldsymbol {u}}}^{{\boldsymbol {n}}_{\boldsymbol {u}}}L({\boldsymbol {u}}q+{\boldsymbol {s}},{\boldsymbol {u}})\Delta {\boldsymbol {u}},\quad \Delta {\boldsymbol {u}}=\Delta u\Delta v,\quad q=\left(1-{\frac {1}{\alpha }}\right)}](https://wikimedia.org/api/rest_v1/media/math/render/svg/439ba309b95250b65a62b64257388b09d20ee38e)